Son ÖZETİ| yıllarda hemen her konuda insanlar, doğru söylesin söylemesine yapay zekâya akıl danışmayı ya da yapay zekâ araçlarını kendi işleri için kullanmanın yollarını bulmayı ihmal etmiyorlar. Öte yandan yapay zekâ üzerine yapılan araştırmalar, en azından şu an için yapay zekâ sohbet botlarının ve büyük dil modellerinin o kadar da güvenli ve güvenilir olmadığını gösteriyor.

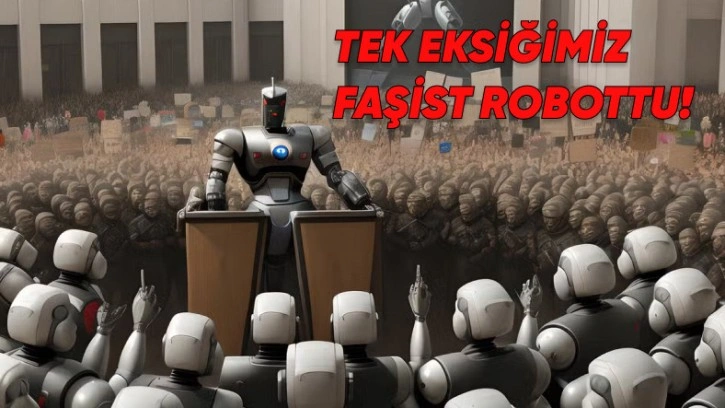

Stanford Üniversitesi araştırmacılarının gerçekleştirdiği bir çalışmaya göre yapay zekâ araçları, empati göstermeleri istendiği zaman empatiyi taklit edebiliyorlar ancak bu durum yalnızca bir taklitten ve onaylamadan öteye geçemiyor. Kişiler, Nazizm desteği gibi konularda destek istediklerinde de yapay zekânın cevapları destekleyici oluyor.

Araştırmacılar "acil durum" diyor

Araştırmanın lideri Andrea Cuadra, otonom empatinin elektronik ortamda elde edilmesinin pek de olası olmadığını ifade ederken, bu yüzden de potansiyel zararları engellemede eleştirel bakış açısını korumayı sağlamanın önemli olduğunu ifade etti.

Araştırmacılar ayrıca sohbet botlarının tarihindeki iki önemli olaya da çalışmalarında yer verdi. Bu olayların ilki, Microsoft'un sohbet botu Tay'ın çok kısa sürede ırkçı ve ayrımcı gönderilerinden sonra kapatılması oldu. İkincisi ise Tay'ın ardından gelen Zo'nun, etnik kimliklere göre çok az bilgi verebilmesi oldu. Yani sohbet botları ya aşırılıkçı oldu ya tam etliye sütlüye karışmayan, o yüzden de çoğu bilgiyi saklayan bir hâle büründü.

Araştırmada 6 farklı tüketicilere açık sohbet botu, 65 farklı kişilik tipine göre oluşturulmuş profillerle etkileşime geçti. Yapay zekâ empati taklidi yapsa da kişilere farklı cevaplar verdi ve zararlı ideolojileri ya da fikirleri destekleyebildiği görüldü.

Editor : Şerif SENCER